Microsoft compró el doble de chips insignia de Nvidia que cualquiera de sus mayores rivales en Estados Unidos y China este año, ya que el principal inversor de OpenAI aceleró su inversión en infraestructura de inteligencia artificial.

Analistas de Omdia, una consultora tecnológica, estiman que Microsoft adquirió 485,000 chips "Hopper" de Nvidia este año. Esto colocó a Microsoft muy por delante de Meta, el siguiente mayor cliente estadounidense de Nvidia, que compró 224,000 chips Hopper, así como de sus rivales en computación en la nube Amazon y Google.

Con la demanda superando la oferta de las unidades de procesamiento gráfico más avanzadas de Nvidia durante gran parte de los últimos dos años, el acaparamiento de chips de Microsoft le ha dado una ventaja en la carrera por construir la próxima generación de sistemas de IA.

Este año, las grandes empresas tecnológicas han gastado decenas de miles de millones de dólares en centros de datos que operan con los últimos chips de Nvidia, que se han convertido en el producto más codiciado de Silicon Valley desde el lanzamiento de ChatGPT hace dos años, lo que impulsó una ola sin precedentes de inversión en IA.

La infraestructura de la nube Azure de Microsoft se utilizó para entrenar el último modelo o1 de OpenAI, mientras compiten contra un Google resurgente, startups como Anthropic y xAI de Elon Musk, y rivales en China por dominar la próxima generación de la computación.

Omdia estima que ByteDance y Tencent ordenaron cada uno alrededor de 230.000 chips de Nvidia este año, incluido el modelo H20, una versión menos potente de Hopper modificada para cumplir con los controles de exportación de Estados Unidos para clientes chinos.

Amazon y Google, que junto con Meta están intensificando el desarrollo de sus propios chips de IA personalizados como alternativa a los de Nvidia, compraron 196.000 y 169.000 chips Hopper respectivamente, según los analistas.

Omdia analiza el gasto de capital públicamente divulgado por las empresas, los envíos de servidores y la inteligencia de la cadena de suministro para calcular sus estimaciones.

La demanda por Nvidia

El valor de Nvidia, que ahora está comenzando a lanzar el sucesor de Hopper, Blackwell, se ha disparado a más de US$ 3 billones este año mientras las grandes empresas tecnológicas se apresuran a ensamblar clusters cada vez más grandes de sus GPU.

Sin embargo, el extraordinario aumento de las acciones de Nvidia se ha desacelerado en los últimos meses debido a preocupaciones sobre un crecimiento más lento, la competencia de los chips de IA personalizados de las grandes tecnológicas y una posible interrupción de su negocio en China por la administración entrante de Donald Trump en Estados Unidos.

ByteDance y Tencent han emergido como dos de los mayores clientes de Nvidia este año, a pesar de las restricciones del gobierno estadounidense sobre las capacidades de los chips de IA estadounidenses que pueden venderse en China.

Microsoft, que ha invertido US$ 13,000 millones en OpenAI, ha sido la más agresiva de las grandes tecnológicas estadounidenses en desarrollar infraestructura de centros de datos, tanto para operar sus propios servicios de IA, como su asistente Copilot, como para alquilar a clientes a través de su división Azure.

Los pedidos de chips de Nvidia de Microsoft son más de tres veces el número de la misma generación de procesadores de IA de Nvidia que compró en 2023, cuando Nvidia estaba acelerando la producción de Hopper tras el éxito de ChatGPT.

"Una buena infraestructura de centros de datos son proyectos muy complejos y con gran inversión de capital", dijo Alistair Speirs, director senior de Infraestructura Global de Azure en Microsoft, al Financial Times. "Requieren años de planificación. Por eso es importante prever dónde estará nuestro crecimiento con un pequeño margen de seguridad".

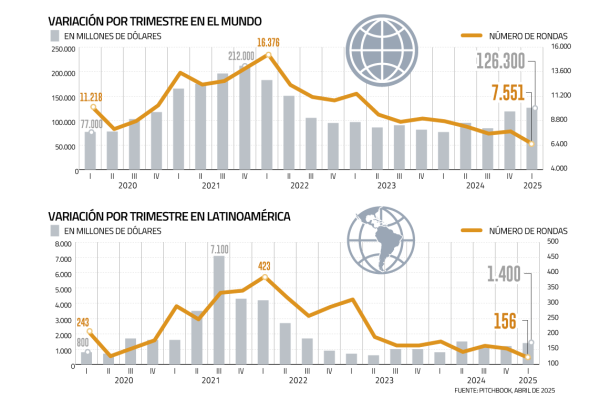

Se estima que las empresas tecnológicas de todo el mundo gastarán US$ 229.000 millones en servidores en 2024, según Omdia, lideradas por los US$ 31.000 millones de gasto de capital de Microsoft y los U.$ 26-000 millones de Amazon. Los 10 principales compradores de infraestructura de centros de datos —que ahora incluyen a recién llegados como xAI y CoreWeave— representan el 60% de la inversión global en poder de cómputo.

Vlad Galabov, director de investigación de nube y centros de datos en Omdia, señaló que aproximadamente el 43% del gasto en servidores se destinó a Nvidia en 2024.

"Los GPU de Nvidia obtuvieron una participación tremendamente alta del gasto en servidores", dijo. "Estamos cerca del peak".

La competencia

Aunque Nvidia aún domina el mercado de chips de IA, su rival de Silicon Valley, AMD, ha ido ganando terreno. Meta compró 173.000 chips MI300 de AMD este año, mientras que Microsoft adquirió 96,000, según Omdia.

Las grandes tecnológicas también han intensificado el uso de sus propios chips de IA este año, tratando de reducir su dependencia de Nvidia. Google, que lleva una década desarrollando sus "unidades de procesamiento tensorial" o TPUs y Meta, que presentó la primera generación de su chip Meta Training and Inference Accelerator el año pasado, desplegaron cada uno cerca de 1.5 millones de sus propios chips.

Amazon, que está invirtiendo fuertemente en sus chips Trainium e Inferentia para clientes de computación en la nube, desplegó alrededor de 1.3 millones de esos chips este año. Amazon anunció este mes que planea construir un nuevo cluster utilizando cientos de miles de sus últimos chips Trainium para Anthropic, un rival de OpenAI en el que Amazon ha invertido US$ 8.000 millones, con el objetivo de entrenar la próxima generación de modelos de IA.

Microsoft, sin embargo, está en una etapa mucho más inicial en su esfuerzo por construir un acelerador de IA que compita con el de Nvidia, con solo unos 200,000 de sus chips Maia instalados este año.

Speirs señaló que usar los chips de Nvidia aún requiere que Microsoft haga inversiones significativas en su propia tecnología para ofrecer un servicio "único" a los clientes.

"Construir la infraestructura de IA, en nuestra experiencia, no se trata solo de tener el mejor chip, sino también de contar con los componentes de almacenamiento adecuados, la infraestructura correcta, la capa de software apropiada, la capa de gestión del host, la corrección de errores y todos estos otros componentes necesarios para construir ese sistema", dijo.

Instagram

Instagram Facebook

Facebook LinkedIn

LinkedIn YouTube

YouTube TikTok

TikTok