Los desafíos de una tecnología capaz de predecir el futuro

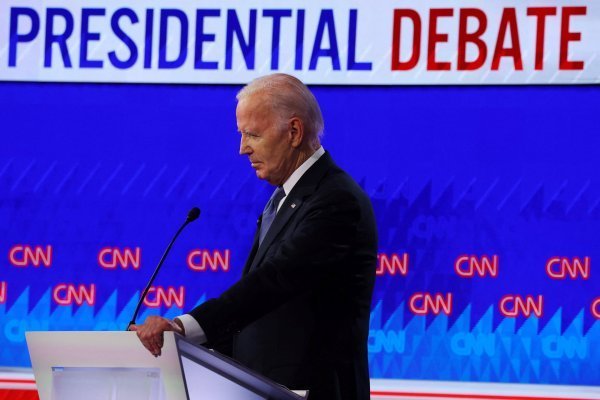

En EEUU algunos jueces ya usan calificaciones de riesgo de reincidencia generadas por computadoras para decidir las sentencias.

- T+

- T-

En 1956, el escritor de ciencia ficción Philip K. Dick publicó el cuento corto “Minority Report”, que planteaba un mundo en el que se habían abolido los crímenes. Unos seres mutantes conocidos como precogniscientes, o “precogs”, podían predecir la identidad de los futuros asesinos con ayuda de la tecnología informática. Los informes de los “precogs” eran usado para arrestar a los sospechosos de “precrímenes”, evitando que los asesinatos se llevaran a cabo.

Además de ser una historia convincente, la historia de Dick representa un brillante análisis de las tensiones entre la capacidad de predicción, la acción humana y los conceptos de culpa y de inocencia. En un punto del libro, John Anderton, jefe de la División de Precrimen, declara: “El hecho de cometer un crimen en sí mismo es una cuestión absolutamente metafísica. Nosotros afirmamos que son culpables. Y ellos, a su vez, afirman constantemente que son inocentes. Y, en cierto sentido, son inocentes”. Y el policía concluye: “En nuestra sociedad no tenemos grandes crímenes, pero tenemos todo un campo de prisioneros lleno de criminales en potencia”.

Justicia virtual

La visión de Dick es grotesca. Sin embargo, es probable que nuestras sociedades estén lentamente dirigiéndose hacia el futuro que él describió. Algunos criminólogos sugieren que algún día podríamos ser capaces de predecir, al momento del nacimiento de un individuo, si va a cometer un delito cuando cumpla los 18 años basados en su entorno y en la historia de sus padres.

En Estados Unidos, algunos jueces ya están utilizando calificaciones de riesgo de reincidencia generadas por computadoras para tomar decisiones en cuestión de sentencias y de libertad condicional. Estos informes comparan los registros de la persona con una cantidad de material relacionado con patrones anteriores de comportamiento criminal y con otros datos demográficos. La promesa es que estos resultados pueden predecir los riesgos para la sociedad mucho más objetivamente que cualquier juez. Unos algoritmos diseñados adecuadamente no debieran ser susceptibles al prejuicio consciente o inconsciente.

Errores tecnológicos

Pero los modelos informáticos sólo son tan buenos como los datos que utilizan. Una investigación de ProPublica, la sala de redacción investigativa, descubrió que el programa de software que utilizaba datos históricos para predecir los futuros criminales sistemáticamente discriminaba contra las personas de raza negra.

Por otra parte, Eric Loomis, un convicto, recientemente objetó el uso de la calificación de riesgo de reincidencia que se utilizó en su sentencia, argumentando que él había recibido castigo adicional por crímenes cometidos por terceros.

El mes pasado, el Tribunal Supremo de Wisconsin rechazó su objeción, pero reconoció que algunos estudios de las calificaciones de riesgo de reincidencia habían “planteado dudas sobre si clasificaban desproporcionadamente a los autores de delitos menores como más propensos a tener un mayor riesgo de reincidencia”.

Estos litigios pueden ser sólo el comienzo de la controversia pública si las agencias de orden público obtienen mayor acceso a los datos que se comparten en línea. Gracias a la digitalización de nuestra sociedad y a las técnicas de aprendizaje de las máquinas, nos estamos volviendo cada vez más adeptos en vigilar –y predecir– el comportamiento.

Estos conjuntos de datos están fragmentados y las agencias del orden público están estrictamente restringidas en relación a qué tienen acceso. Pero, a medida que crece el clamor por una respuesta más enérgica ante los atentados terroristas, el peligro es que las tecnologías de predicción se vuelvan ininterrumpidas, y subrepticiamente, más invasivas.