Amazon está a punto de lanzar sus nuevos chips de inteligencia artificial, en un momento en que el grupo Big Tech busca rentabilizar sus multimillonarias inversiones en semiconductores y reducir su dependencia del líder del mercado, Nvidia.

Los ejecutivos de la división de computación en nube de Amazon están gastando mucho en chips personalizados con la esperanza de aumentar la eficiencia de sus docenas de centros de datos y, en última instancia, reducir sus propios costos y los de los clientes de Amazon Web Services (AWS).

La iniciativa está encabezada por Annapurna Labs, una startup de chips con sede en Austin que Amazon adquirió a principios de 2015 por US$ 350 millones. Se espera que el último trabajo de Annapurna se exhiba el mes que viene, cuando Amazon anuncie la disponibilidad generalizada de «Trainium 2», parte de una línea de chips de IA destinados a entrenar a los modelos más grandes.

Trainium 2 ya está siendo probado por Anthropic, el competidor de OpenAI que ha conseguido US$ 4 mil millones de financiación de Amazon, así como por Databricks, Deutsche Telekom y las japonesas Ricoh y Stockmark.

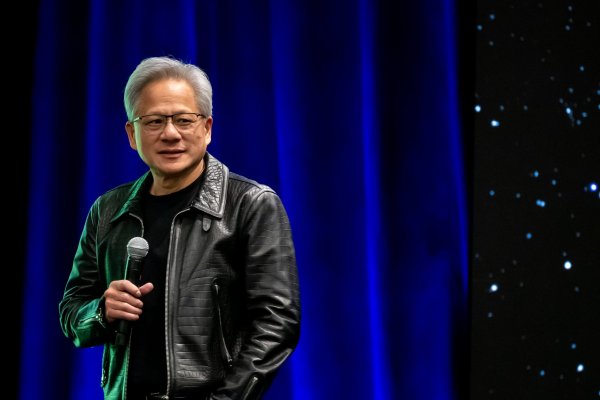

El objetivo de AWS y Annapurna es enfrentarse a Nvidia, una de las empresas más valiosas del mundo gracias a su dominio del mercado de procesadores de IA.

"Queremos ser absolutamente el mejor lugar para Nvidia", dijo el vicepresidente de servicios de computación y redes de AWS, Dave Brown. "Pero al mismo tiempo creemos que es saludable tener una alternativa". Amazon dijo que Inferentia, otra de sus líneas de chips especializados en IA, ya es un 40% más barato de ejecutar para generar respuestas a partir de modelos de IA.

"El precio (de la computación en nube) tiende a ser mucho mayor cuando se trata de aprendizaje automático e IA", afirmó Brown. "Cuando te ahorras el 40% de mil dólares, en realidad no va a afectar a tu elección. Pero cuando estás ahorrando un 40% en decenas de millones de dólares, sí lo hace».

Amazon espera ahora alrededor de US$ 75 mil millones de dólares en gasto de capital en 2024, la mayoría en infraestructura tecnológica. En la última llamada de resultados de la empresa, el consejero delegado Andy Jassy dijo que espera que la empresa gaste aún más en 2025.

Esto representa un aumento con respecto a 2023, cuando gastó US$48,4 mil millones de dólares en todo el año. Los principales proveedores de servicios en la nube, incluidos Microsoft y Google, están inmersos en una carrera de inversiones en IA que no parece que vaya a remitir.

Amazon, Microsoft y Meta son grandes clientes de Nvidia, pero también están diseñando sus propios chips para centros de datos con el fin de sentar las bases de lo que esperan que sea una oleada de crecimiento de la IA.

"Cada uno de los grandes proveedores de la nube está avanzando febrilmente hacia una pila (de tecnología de chips) más verticalizada y, si es posible, homogeneizada e integrada", afirmó Daniel Newman, de The Futurum Group.

"Todos, desde OpenAI hasta Apple, quieren fabricar sus propios chips", señaló Newman, ya que buscan “menores costes de producción, mayores márgenes, mayor disponibilidad y más control”. "No se trata (solo]) del chip, sino del sistema completo", afirmó el director de ingeniería de Annapurna y veterano de Arm e Intel de SoftBank, Rami Sinno.

Para la infraestructura de IA de Amazon, eso significa construir todo desde cero, desde la oblea de silicio hasta los bastidores de servidores en los que encajan, todo ello sustentado por el software y la arquitectura propios de Amazon. "Es muy difícil hacer lo que hacemos a gran escala. No muchas empresas pueden hacerlo", aseguró Sinno.

Tras empezar construyendo un chip de seguridad para AWS llamado Nitro, Annapurna ha desarrollado desde entonces varias generaciones de Graviton, sus unidades centrales de procesamiento basadas en Arm que proporcionan una alternativa de bajo consumo a los tradicionales caballos de batalla de servidor proporcionados por Intel o AMD.

Según Dan Hutcheson, analista de TechInsights, "la gran ventaja para AWS es que sus chips consumen menos energía y sus centros de datos pueden ser un poco más eficientes", lo que reduce los costes. Si las unidades de procesamiento gráfico de Nvidia son potentes herramientas de uso general -en términos automovilísticos, como una ranchera o un familiar-, Amazon puede optimizar sus chips para tareas y servicios específicos, como un compacto o un utilitario, afirmó.

Hasta ahora, sin embargo, AWS y Annapurna apenas han hecho mella en el dominio de Nvidia en infraestructura de IA.

Nvidia registró unos ingresos de US$ 26,3 mil millones por la venta de chips para centros de datos de IA en su segundo trimestre fiscal de 2024. Esa cifra es la misma que Amazon anunció para toda su división AWS en su propio segundo trimestre fiscal, de la que solo una fracción relativamente pequeña puede atribuirse a clientes que ejecutan cargas de trabajo de IA en la infraestructura de Annapurna, según Hutcheson.

En cuanto al rendimiento bruto de los chips de AWS en comparación con los de Nvidia, Amazon evita hacer comparaciones directas y no somete sus chips a pruebas de rendimiento independientes.

El consultor de chips de Moor Insights & Strategy, Patrick Moorhead, afirmó: "Los puntos de referencia son buenos para esa fase inicial: 'oye, ¿debería siquiera considerar este chip"', pero la verdadera prueba es cuando se ponen "en múltiples bastidores unidos como una flota".

Moorhead confía en la veracidad de las afirmaciones de Amazon de que el rendimiento de Trainium 1 y Trainium 2 se ha multiplicado por 4, ya que lleva años analizando a la empresa. Pero las cifras de rendimiento pueden importar menos que el simple hecho de ofrecer más opciones a los clientes.

"La gente aprecia toda la innovación que ha aportado Nvidia, pero nadie se siente cómodo con que Nvidia tenga el 90% de la cuota de mercado", añadió. "Esto no puede durar mucho".

Instagram

Instagram Facebook

Facebook LinkedIn

LinkedIn YouTube

YouTube TikTok

TikTok